Cherry Studio 是一款支持多个大语言模型(LLM)服务商的桌面客户端以及本地模型(通过 Ollama 等运行),不仅支持多模型同时对话,还能创建智能体、文生图、AI翻译,处理多种文件格式,并且兼容 Windows、Mac 和 Linux 系统。内置 300 多个预配置 AI 助手,用户还可以自定义专属助手以满足个性化需求。本文将详细的介绍如何在本地部署 Cherry Studio 并结合路由侠实现外网访问本地部署的 Cherry Studio 。

第一步,本地部署安装 Cherry Studio

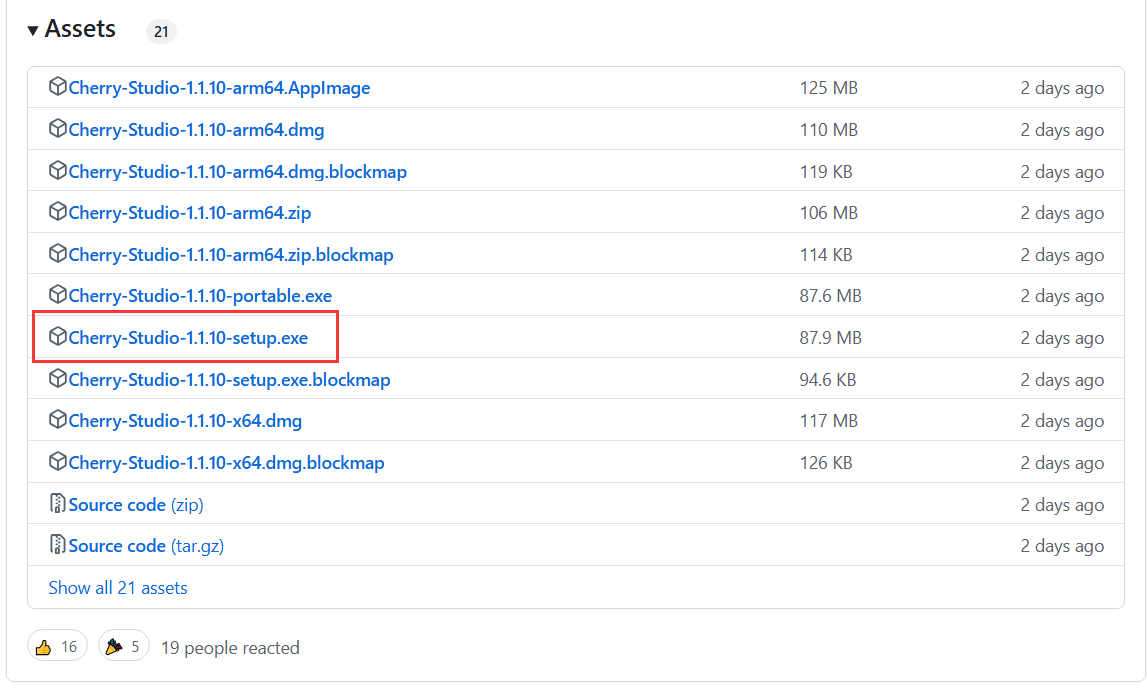

1,进入 Cherry Studio 的 github 主页下载客户端:https://github.com/CherryHQ/cherry-studio/releases 。如下图,找到 Windows 版本客户端安装程序下载即可。

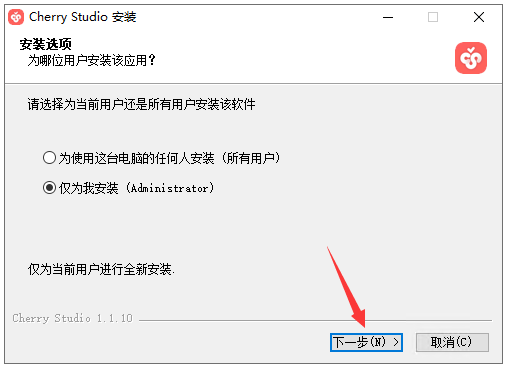

2,双击程序开始安装,点击【下一步】。

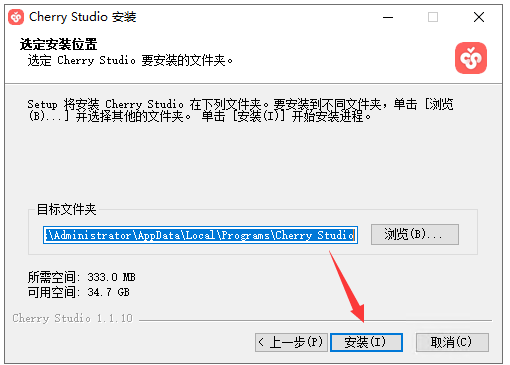

3,选择文件夹后,点击【安装】。

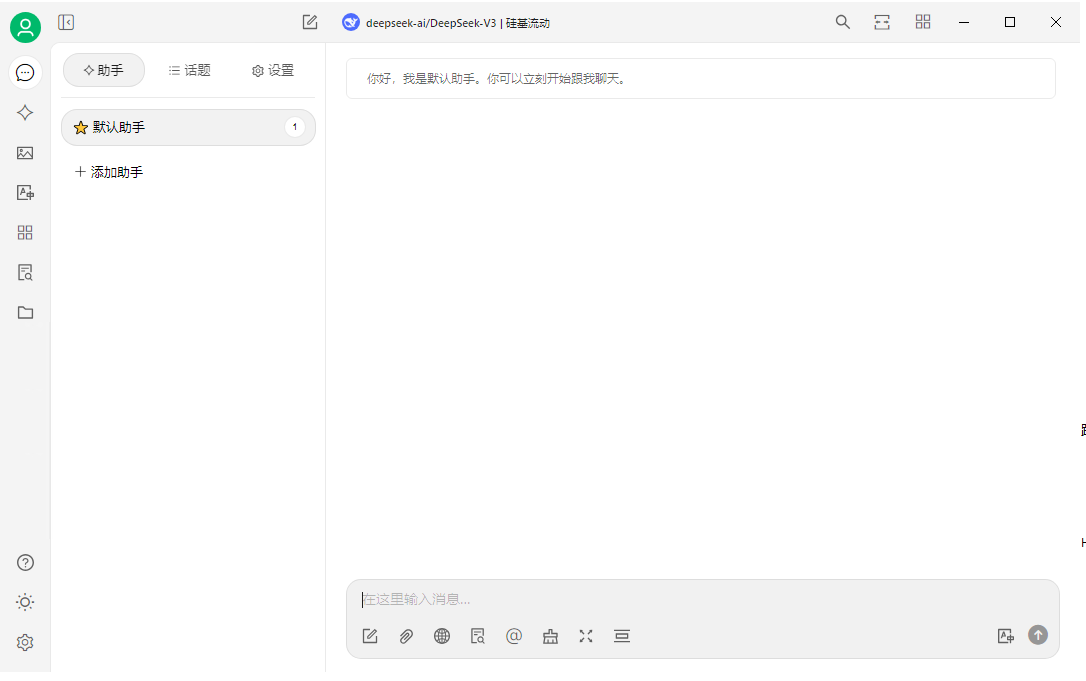

4,安装好后,打开 Cherry Studio 软件,就能看到 AI 对话界面。

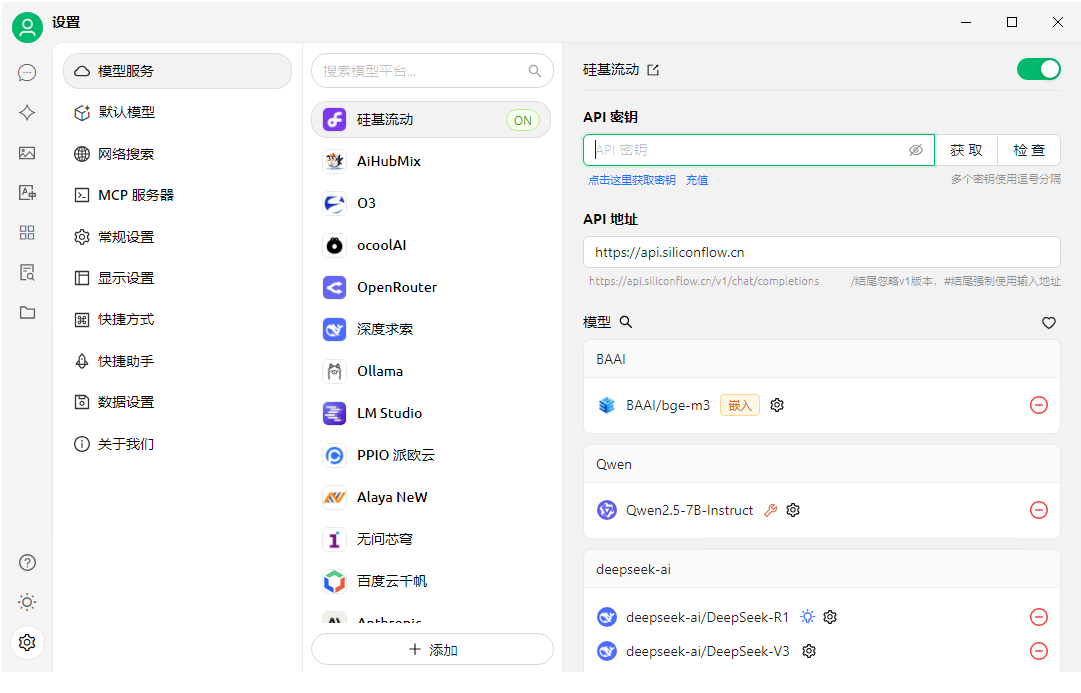

5,点击左下角的设置,就可以进行模型服务配置。这里以硅基流动的模型服务为演示,如果你本地没有部署 deepseek 等大模型,只要添加好 API 秘钥就能在 Cherry Studio 客户端中在线使用 deepseek 大模型了。

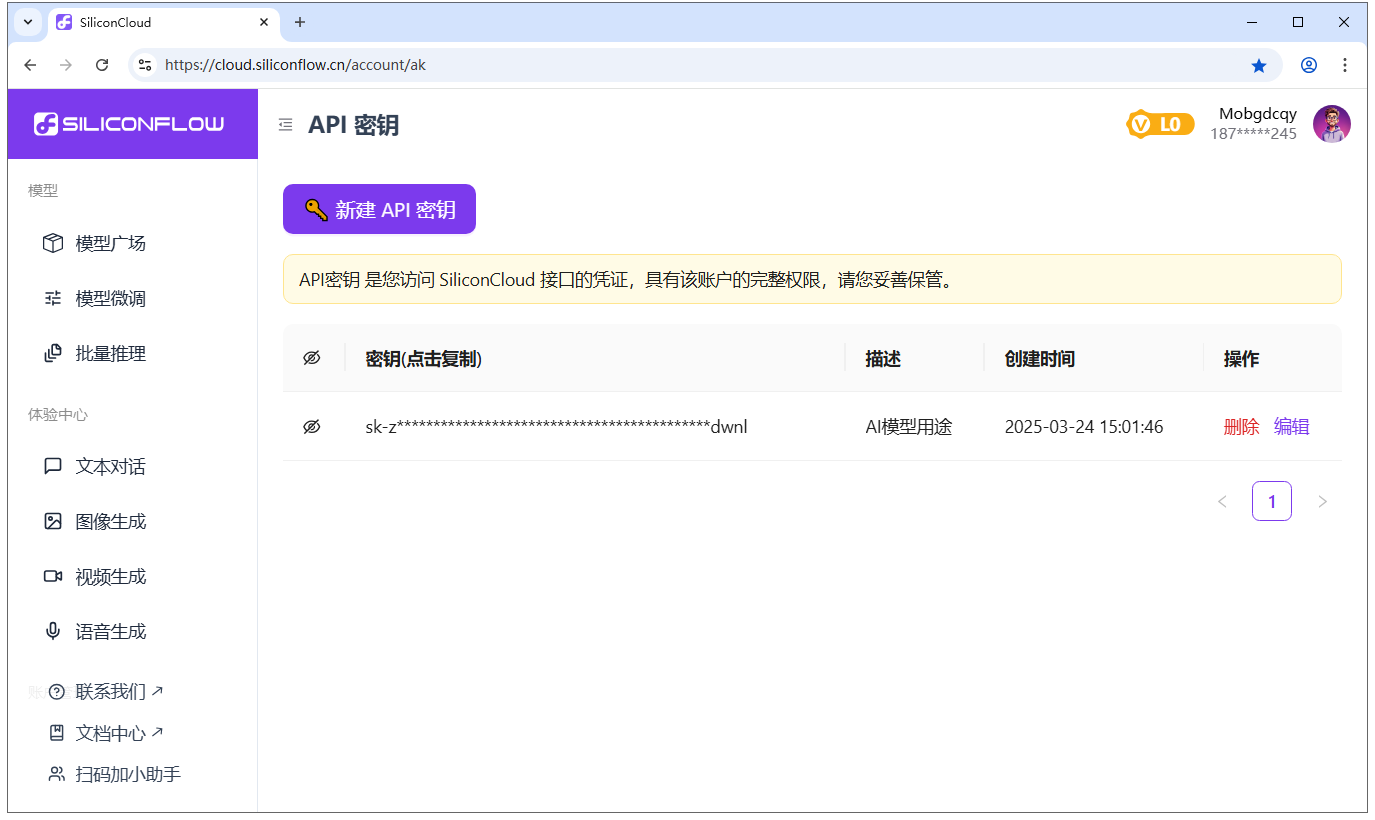

6,如果你还没有它的 API 密钥,点击获取密钥,在跳转的页面注册一个账号就能免费获得你的 API 密钥,点击复制。

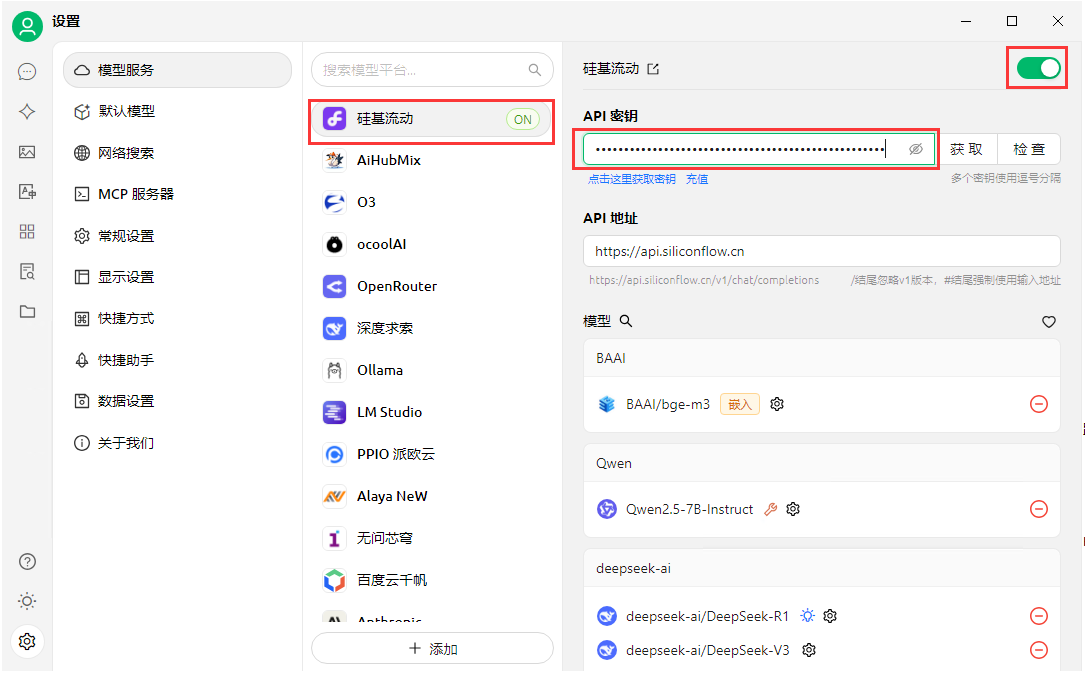

7,将复制的密钥粘贴到 Cherry Studio 客户端中 API 密钥框中,确定右上角的开关打开状态即可。然后往下拉点击底部的【管理】按钮。

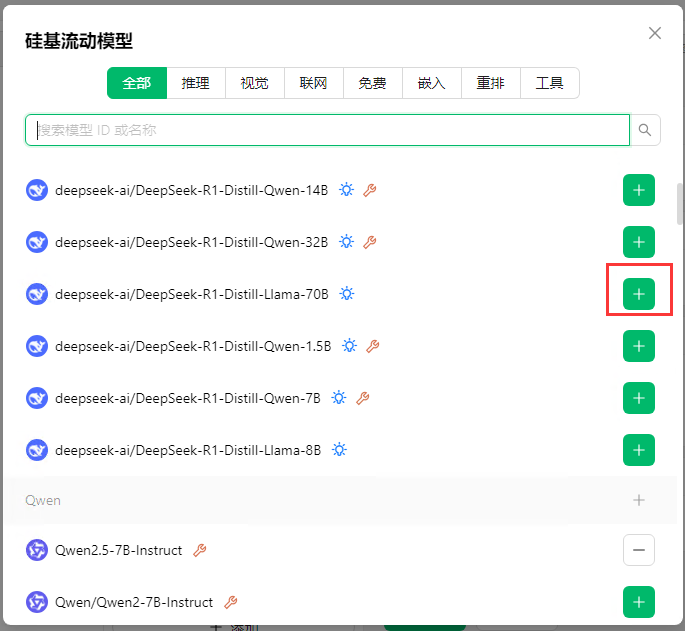

8,这里会出现可以使用的几十种大模型。

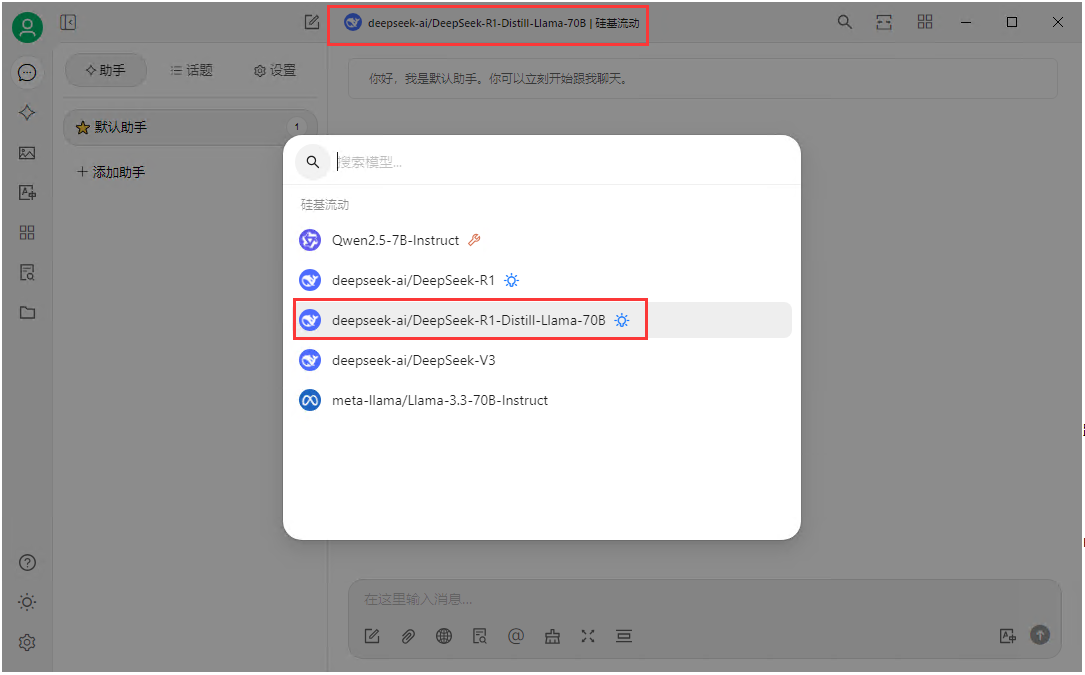

9,点击加号就可以模型,这里以添加 deepseek-r1-70b 模为例。

10,返回到对话界面,如下图,在界面上方选择添加的 AI 模型。

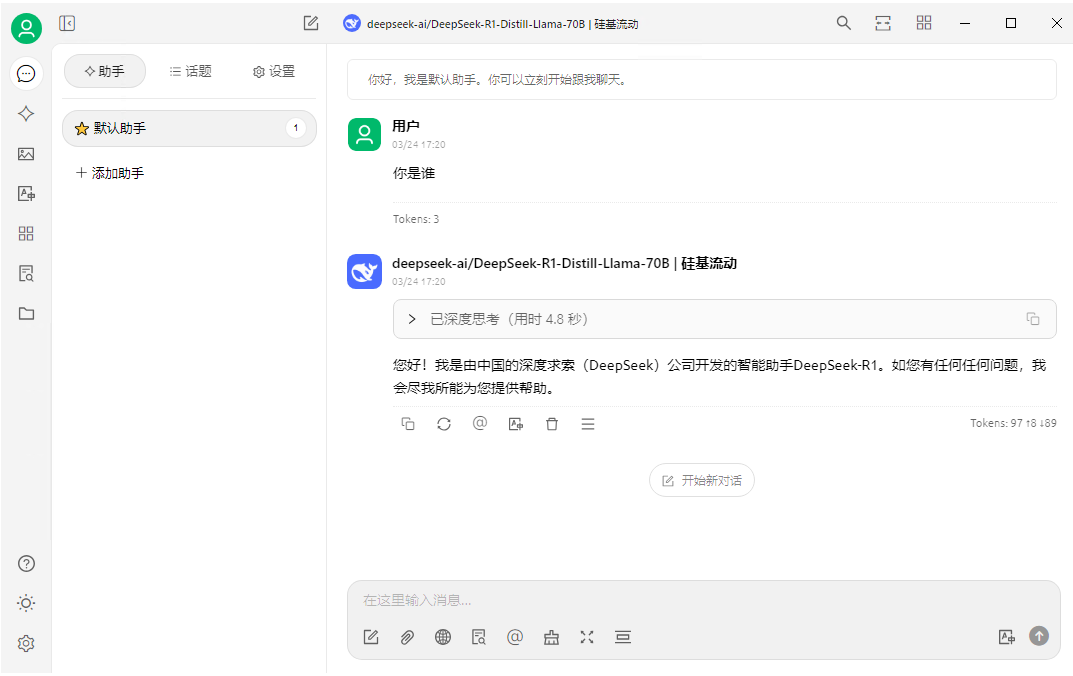

11,然后就可以和 AI 大模型对话了!

第二步,配置本地模型服务

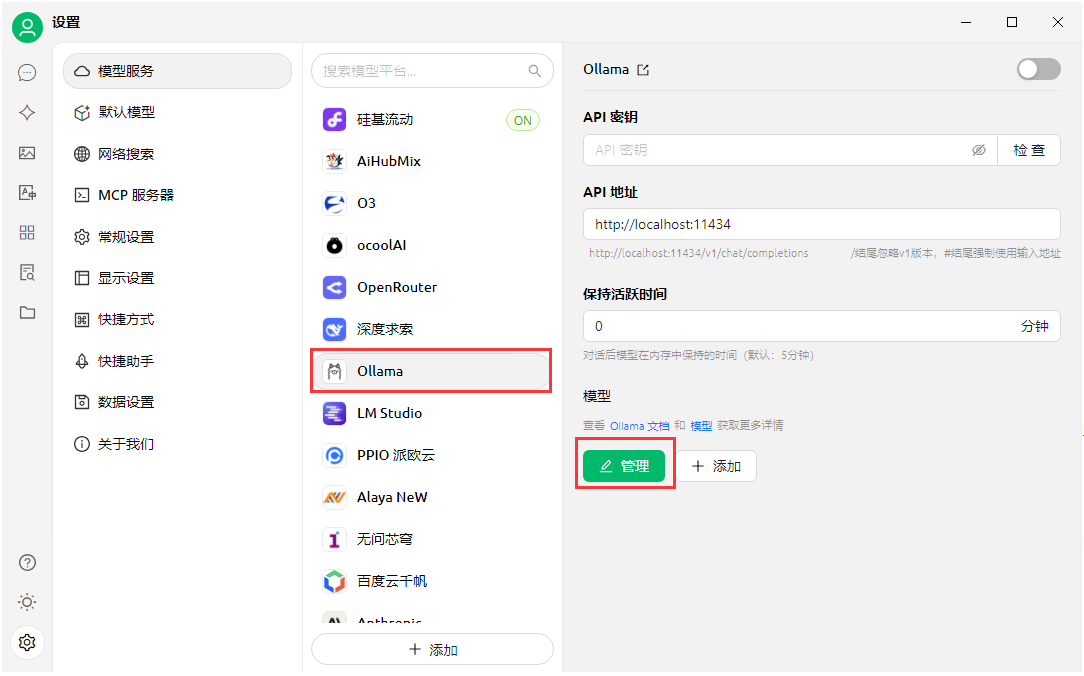

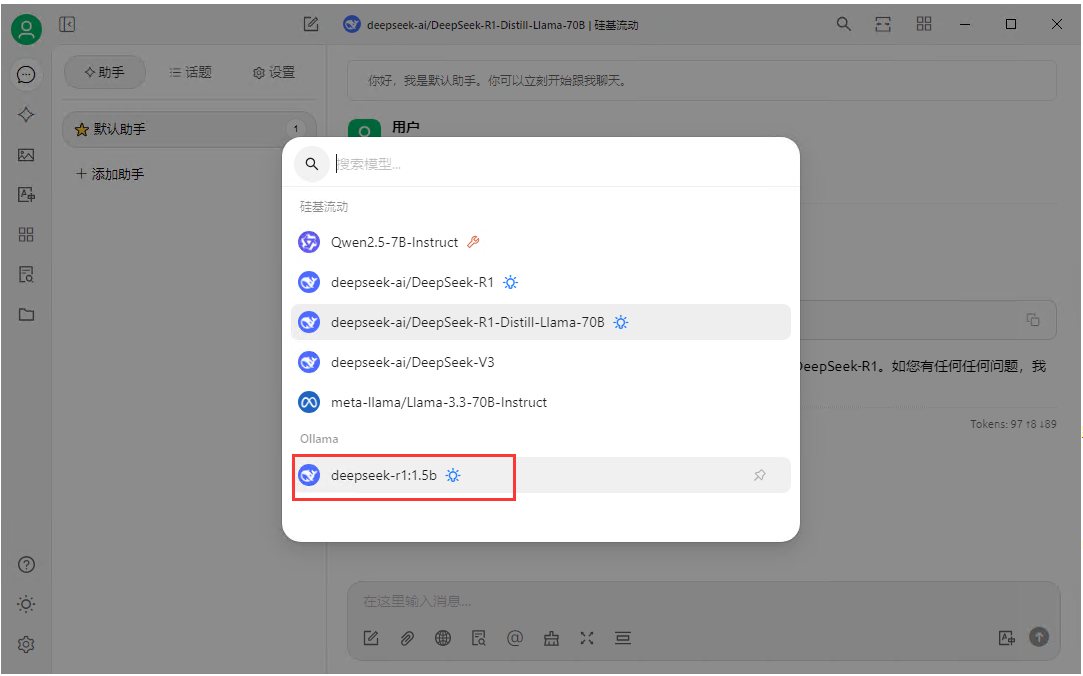

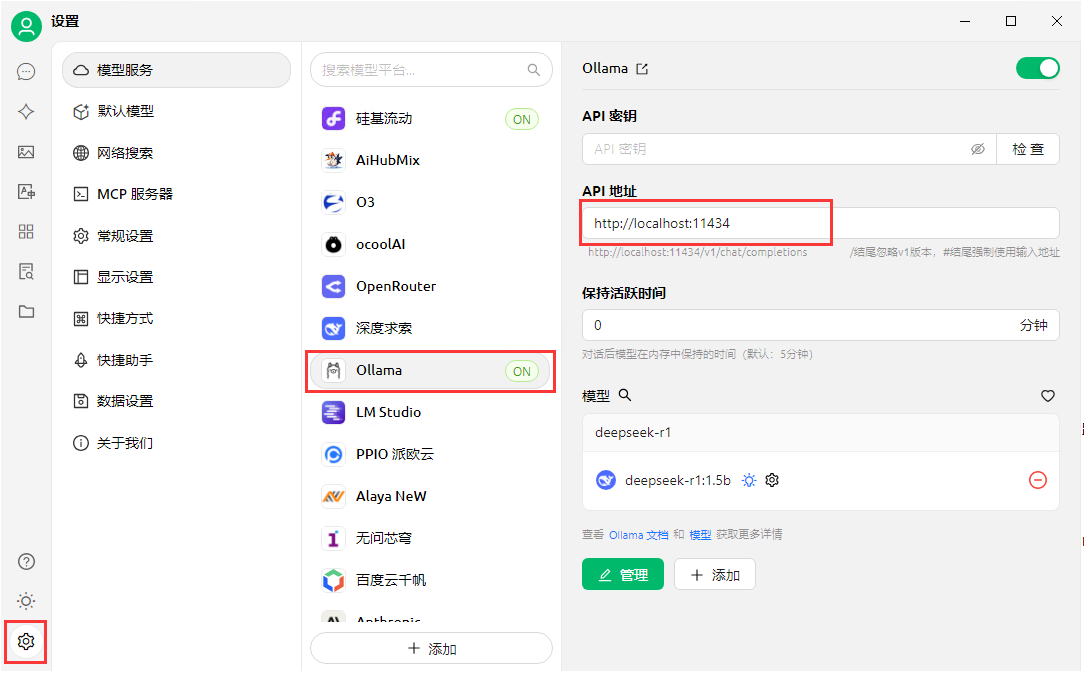

1,如果你已经在本地服务器中部署了 AI 大模型,那可以在 Cherry Studio 客户端中配置本地模型服务,免费与大模型聊天,想用就用。同样在设置界面找到 ollama ,点击【管理】。

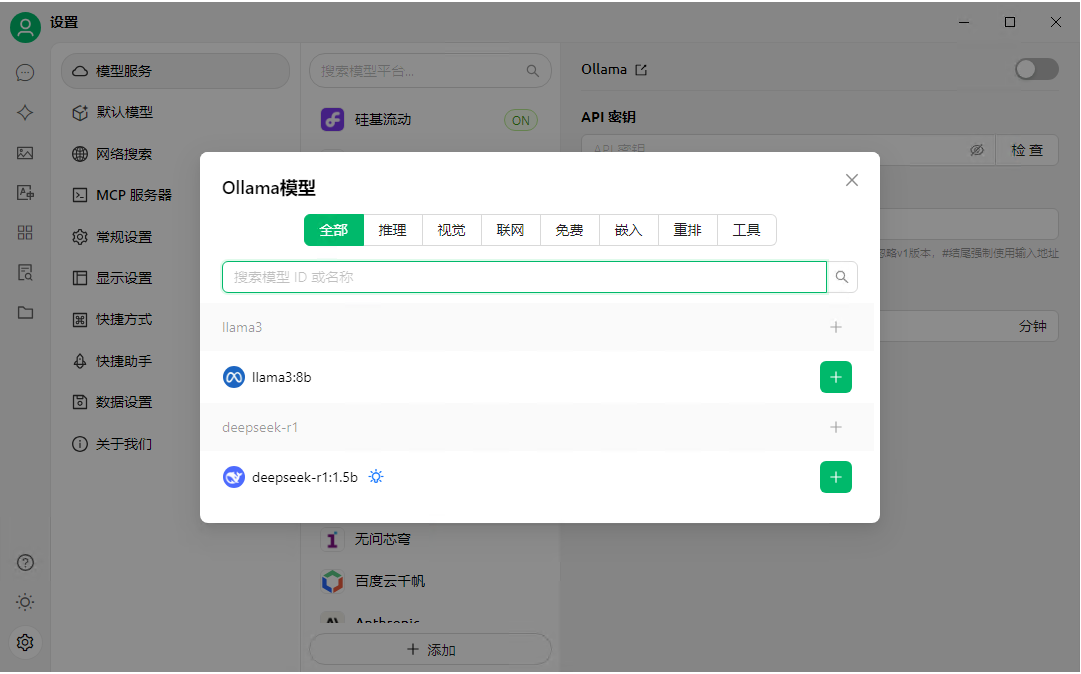

2,可以看到我们之前在本地已经部署好的模型。点击加号添加即可。

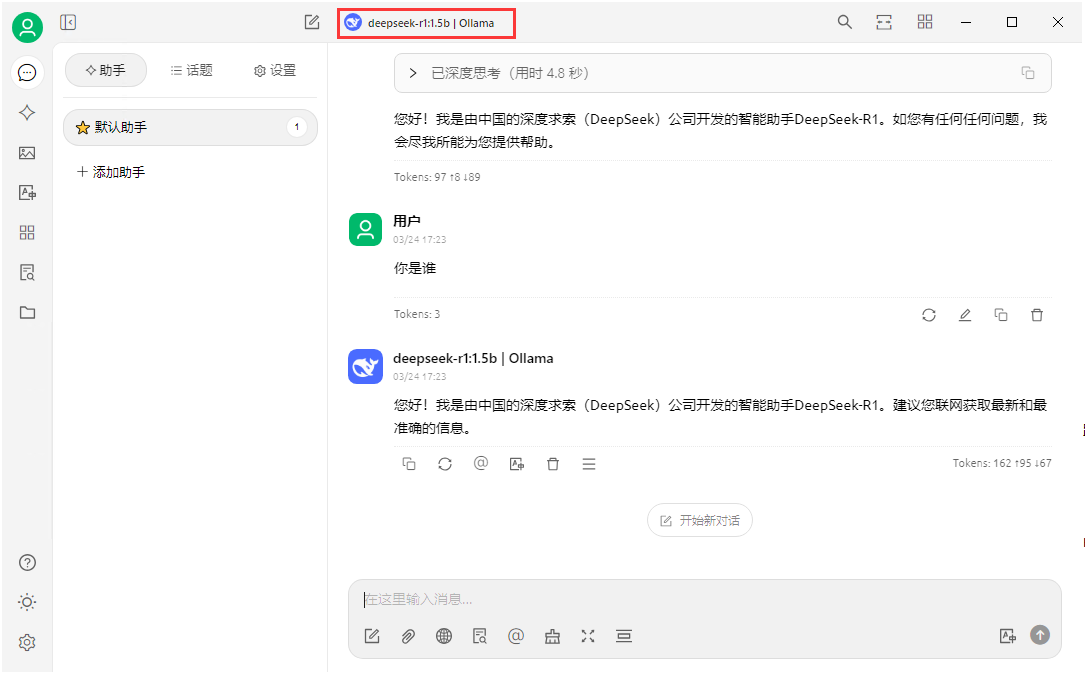

3,在对话界面的上方选择本地部署的 AI 模型。

4,选择好后就可以直接对话了。

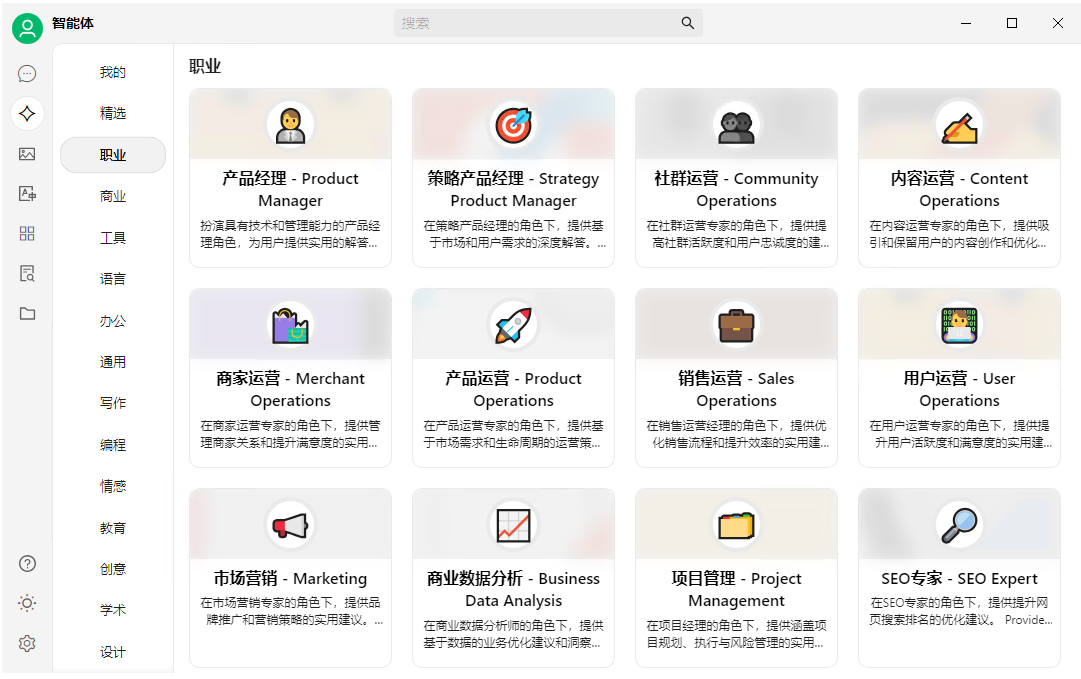

5,这款 Cherry Studio 有很多功能,比如在聊天助手下的智能体功能,用户可以根据不同的使用场景选择自己需要的智能体模版进行创建。

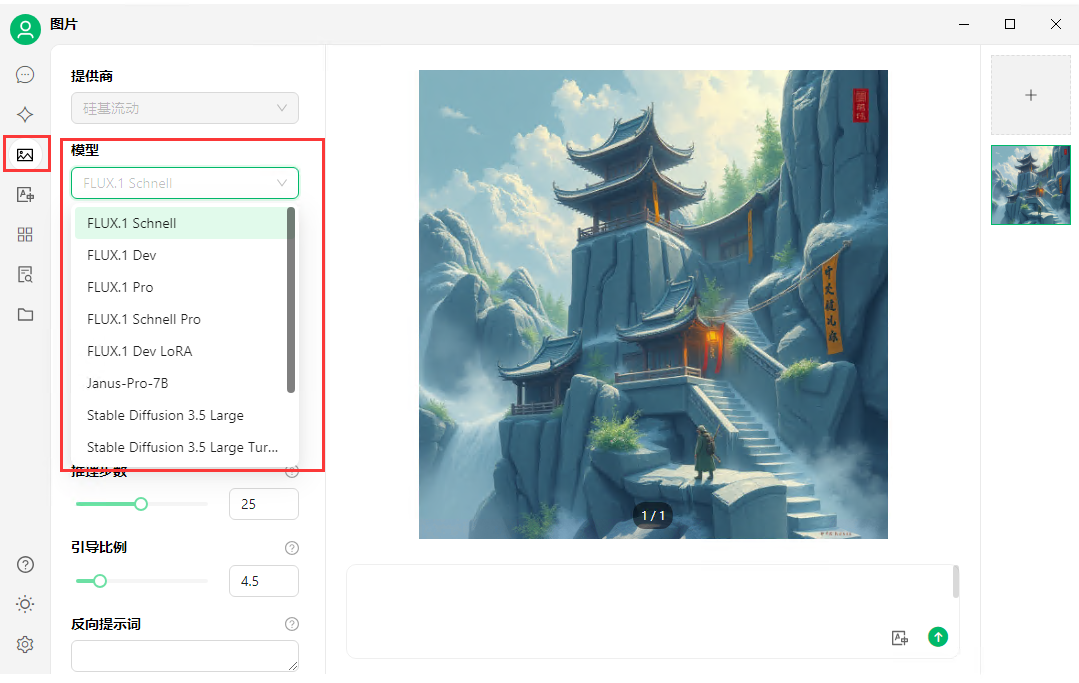

6,下方的图片功能可以选择模型进行 AI 绘图。

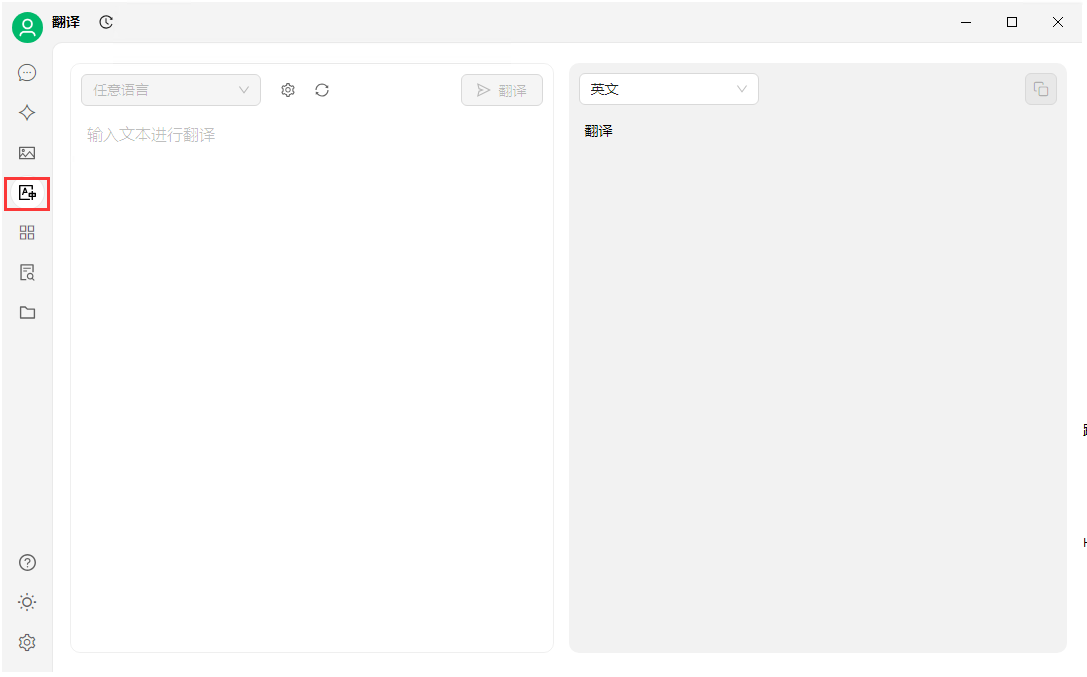

7,还有 AI 翻译功能等等。

第三步,外网访问本地的 Cherry Studio

很多小伙伴需要出差,或者在家办公的,就需要实现不在同一网络环境下,也能随时随地在线使用 Cherry Studio 客户端远程调用本地部署的 AI 大模型聊天与办公,那就需要借助路由侠内网穿透工具来实现外网访问了。

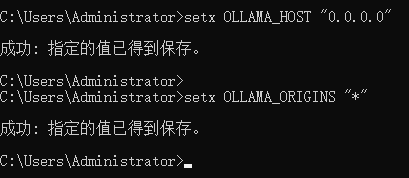

1,前面我们在配置本地模型服务时,使用的是在本地安装好的 ollama 接入大模型,想要远程调用大模型,需要进行对 ollama 进行一下环境变量设置。打开 cmd 终端,执行下面两个命令:

setx OLLAMA_HOST "0.0.0.0"

setx OLLAMA_ORIGINS "*"

2,在模型服务中选择 Ollama,打开右上角的开关,可以看到默认端口为 11434 。

在内网的电脑上安装路由侠,点此下载

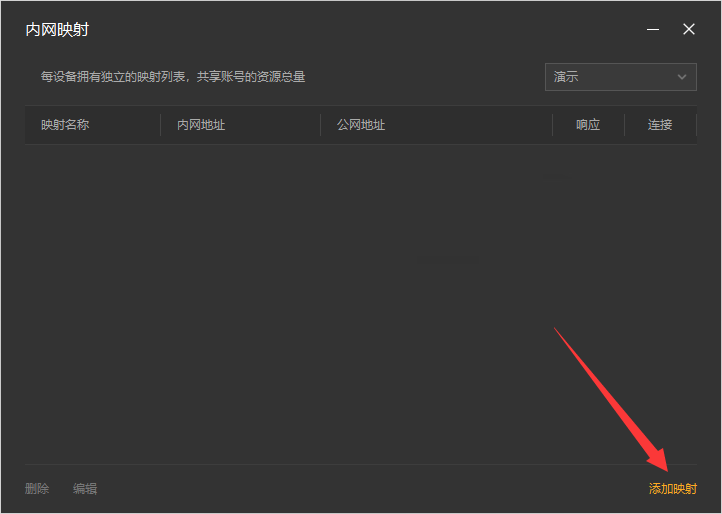

1,下载安装完成后,打开路由侠界面,点击【内网映射】。

2,点击【添加映射】。

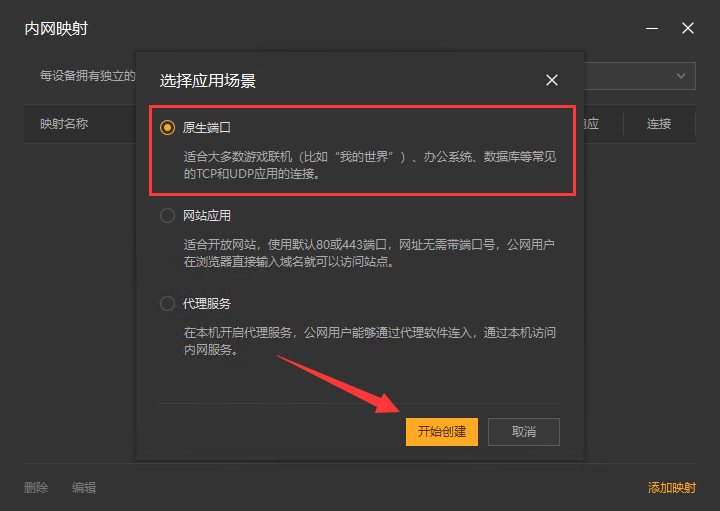

3,选择【原生端口】。

4,在内网端口里填写 ollama 的默认端口 11434 后点击【创建】按钮,如下图。

5,创建好后,就可以看到一条映射的公网地址,鼠标右键点击【复制地址】。

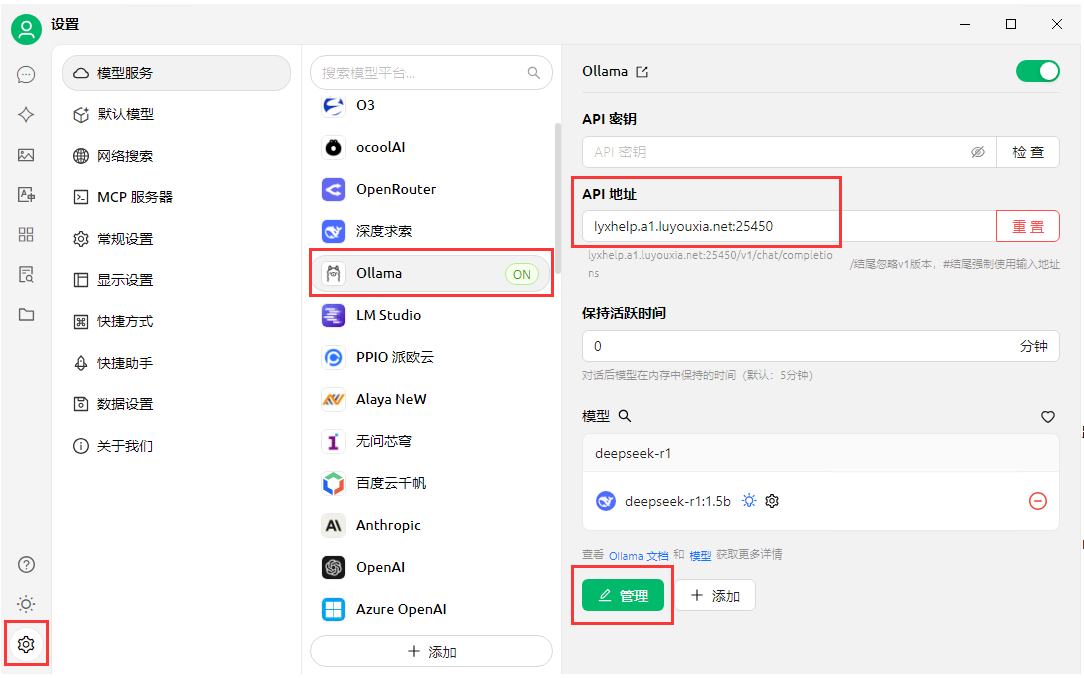

6,在外网的电脑上,如下图,把从路由侠复制过来的公网地址粘贴到 Ollama 的 API 地址栏中,点击【管理】。

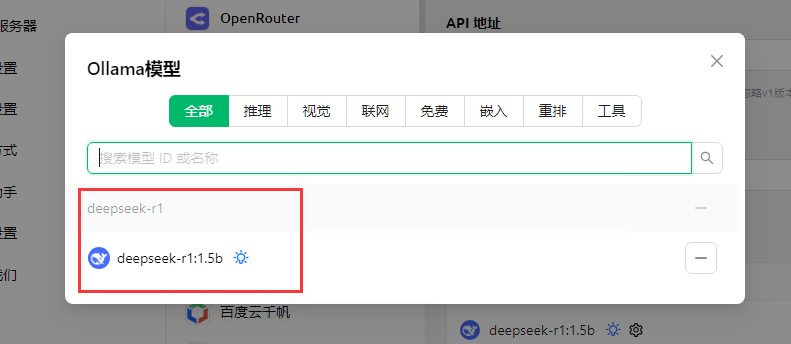

7,可以看到即使不在同一网络环境下,也能看到在本地部署的模型。点击添加按钮,返回到对话界面就可以和 AI 模型对话了!

以上就是在本地局域网内部署 Cherry Studio 大模型以及利用路由侠内网穿透实现外网访问的全部教程了,如果想要对路由侠有更多的了解,可以进官网详细了解,路由侠官网地址:www.luyouxia.com